文献分享 Vol. 4|量化叙事相似性

Waight et al., 2025 | Sociological Methods & Research

概要

近年来,学界对「叙事」的关注日益增加。与传统文本分析常常聚焦于情绪、道德框架或主题等指标不同,叙事研究强调的是信息的结构化表达,本文所强调的「叙事相似性」不仅仅意味着文章是否共享同一广泛主题或某些精确的文本特征,而是强调在具体事件、主张与行动者层面上,文本之间是否存在叙事共性。这一转向为理解社会传播过程提供了更细致的工具。在这一背景下,本文以「新闻流动」为切入点,探讨了跨国媒体叙事扩散的问题。作者特别关注美国新闻网站与俄罗斯国家媒体在「生物武器」议题上的叙事重合。研究发现,低质量的美国新闻网站更容易复述俄罗斯媒体的叙事,这种倾向部分可归因于其更依赖其他媒体的报道,而非原创生产。由此,文章不仅丰富了对跨国信息传播的认识,也展示了叙事作为分析单元在解释媒体相互依赖和信息扩散中的独特价值。本文的另一大亮点在于 Validation 部分。叙事相似性的测量常常依赖无监督方法,但传统的验证方式往往存在缺陷,尤其难以在召回率 (recall) 上获得可靠指标。作者通过设计将无监督问题转化为稀有事件的监督学习问题,从而能够在 precision、recall、F1 三个维度上系统地比较不同方法。这一方法学上的创新不仅提升了研究结果的可信度,也为后续叙事研究提供了可复制的验证框架。

什么是叙事相似性

定义

什么是叙事?我们为什么使用”叙事相似性”这一术语?既有研究将叙事定义为事件或事件序列的表征,这些事件在时间上和/或因果上彼此相连 (Ryan, 2007)。叙事被用来讲述一个关于潜在事件序列的故事 (Rudrum, 2005),从而将原本分散的行动者与行动组织成一个可理解的情节 (Polletta et al., 2011, Somers, 1994)。正是这些叙事行为构成了社会学家在研究文本时提出诸多问题的基础 (Abell, 2004, Franzosi, 1998, Stuhler, 2022)。尽管社会学对叙事的研究通常聚焦于个体行动者关于其生命历程、身份与决策过程的讲述 (Frost, 2019, Kiviat, 2019, Somers, 1994),但叙事的概念在新闻社会学中同样具有重要意义,并且与新闻生产者如何向受众框定事件密切相关 (Bail, 2012, Fiss and Hirsch, 2005, Gamson and Modigliani, 1989)。近年来,国际关系研究将叙事的概念拓展至”战略叙事”,即有意地运用叙事来推动组织和国家目标的实现 (Miskimmon et al., 2014)。研究尤其关注修正主义大国——例如俄罗斯与中国——如何通过对媒体体系的控制,在海外发动”软实力”影响行动 (Fan et al., 2024, Guo et al., 2019, Khaldarova and Pantti, 2020, Roselle et al., 2014, Szostek, 2017, Zhandayeva, 2024),并试图干预外部媒体环境 (Eady et al., 2023, Golovchenko et al., 2020)。例如,俄罗斯在其全球媒体运作上投入了大量资源,通过国家媒体如”今日俄罗斯”(RT)以多种语言生产内容 (Elswah and Howard, 2020, Redington, 2021)。关于媒体环境中叙事战略竞争的文献引发了广泛关注,学者们尝试量化估计不同叙事在各类语境中的扩散程度,并由此评估俄罗斯等国在其媒体影响行动中的实际成效 (Ash et al., 2024, Hanley et al., 2023, 2025)。我们的研究正是融入这一研究脉络之中。基于我们对叙事的理解——即作为对潜在事件、行动者与对象的故事与表征——我们将”叙事”界定为围绕某一具体现象/事件/主体或其组合展开的一系列主张、论点或框架。我们将”叙事相似性”在文档层面上界定为:文本在多大程度上对相同潜在事件提出相同主张。

之前研究的不足

-

缺乏验证与性能评估。现有研究大多没有提供 out-of-sample 的验证指标,尤其缺少对 recall 的估计,这掩盖了方法在找回目标文档集时的不足。本文提出利用人工标注的 gold standard 数据开展 out-of-sample 验证,并证明我们的方法在 precision 和 recall 上均优于相关替代方法。

- 过去的方法在概念上存在偏差:我们的研究目标是”叙事相似性”,而既有方法的估计量往往与之不符。

- 文本重用方法(Boumans et al., 2018; Cagé et al., 2020; Nicholls, 2019; Niculae et al., 2015; Saridou et al., 2017):依赖作者逐字复制文本,因此若两个文档存在大段重合,可以较可靠地认定其共享叙事。但该方法无法识别意译、提炼信息并加入新细节的情形,即使采用更灵活的语义变化和图划分方法(Leskovec et al., 2009)也难以解决。尤其在新闻媒体研究中,由于伦理与版权限制,直接文本复制较少,因此极易导致 false negatives;同时,该方法也局限于单语环境,无法处理跨语言的叙事相似性。

- 主题模型方法(Ceron et al., 2021; Ghasiya and Okamura, 2021; Krawczyk et al., 2021; Madrid-Morales, 2021; Ng et al., 2021):能够聚合语义不同但话题相关的文本,但作为估计量,其与媒体中的文本重用和扩散机制脱节。主题模型识别的是话题相似性,而不是更细微的主张、证据或具体事件,因此在叙事相似性任务中往往会产生大量 false positives。

- 关系抽取与语义标注方法(Ash et al., 2024; Stuhler, 2022, 2024):利用命名实体识别、依存句法、语义角色标注等方法来构建文档内部的关系网络,延续了社会学中基于区块建模与网络分析的传统(Bearman et al., 1999; Mische and Pattison, 2000; Mohr, 1998)。这一方法能识别丰富的叙事元素,例如 动作主体—动作—受事 的关系模式,用于研究竞选言说或文学叙事(Stuhler, 2022, 2024; Ash et al., 2024)。但这些方法聚焦于单个主张或叙事元素,缺乏对文档层面整体叙事语境的把握。

- 人机结合方法的局限。另一种有前景的方法是采用”human-in-the-loop”的方式来测量叙事相似性,该方法结合了语义相似性计算与人工标注。Lu 等人 (2024) 将这一方法应用于研究中国微博上的推文,识别其中是否包含与推特上关于新冠肺炎(COVID-19)的信息。他们首先利用 Universal Sentence Encoder (USE) 生成微博和推特文本的向量嵌入,并据此计算语义相似度,从而根据微博与最常被转发的推特内容的相似程度对微博文本进行排序。随后,他们再由人工标注员对这些候选文本进行判断,以确认哪些微博确实包含了与推特相同的信息及相关主张。这一方法被视为识别叙事相似性的”黄金标准”:在资源无限的情况下,它可以被认为是最理想的叙事相似性识别方式。然而,其主要挑战在于缺乏可扩展性。由于人工评估耗时且成本高昂,该方法往往只能覆盖最突出的案例,而难以捕捉到更大范围内的叙事分布。尽管如此,我们仍借助这一方法来构建 “gold-standard” 的召回率验证数据集,其细节将在下文的有效性验证部分中进一步说明。

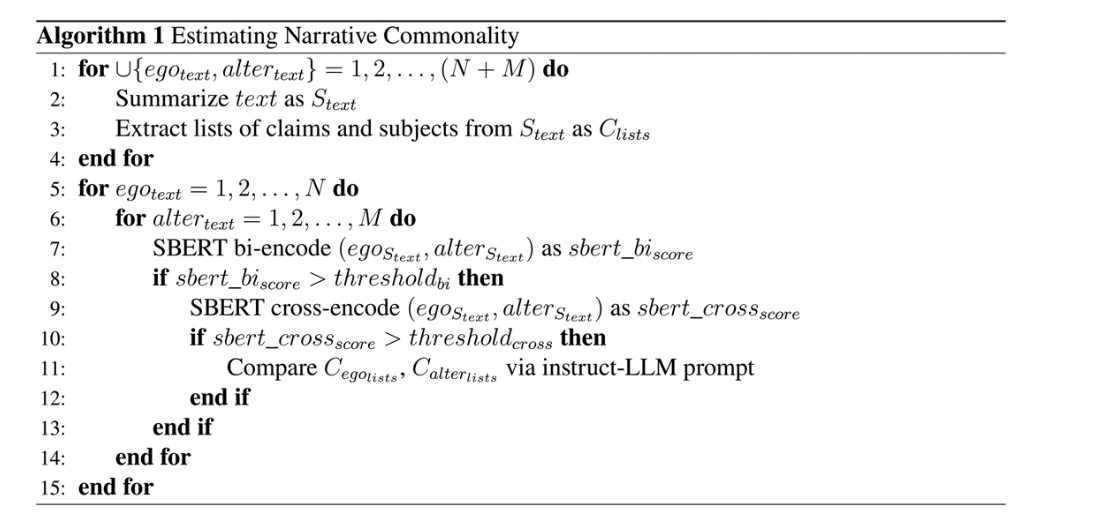

方法简述

在本文中,我们展示了上述方法对于我们的任务而言均不够充分,并提出了一种能够显著改进这些基线方法的替代性测量方式。任何试图衡量叙事相似性的研究都必须谨慎考虑 estimand 与 estimator 的对应关系 (Lundberg et al., 2021)。在这里,我们的 estimator 是下文介绍的 LLM-SBERT 方法,而我们的 estimand 是文档对之间的叙事相似性,特别关注其中的关键主张与主题。具体而言,我们使用大语言模型 (LLMs) 将文档两两进行比较,以评估每一对文档是否确实就相同的特定事件提出了相同的具体主张。我们之所以采用 LLMs,是因为与此前遇到的所有自然语言技术不同,instruction-tuned LLMs 已经被证明能够以令人印象深刻的量化水平完成这一任务 (see validation section below)。然而,尽管该方法解决了许多问题,它在应用于大规模语料时仍需要额外的方法来实现扩展。如果要将所有文章两两比较,其成对比较的数量和计算量会急剧增长(以 (n²−n)/2 的速度增加)。因此,为了识别共享相同叙事的文章,我们采用了三个步骤来平衡这一权衡。第一步,我们使用 LLMs 基于 “concept-guided chain of thought” (Wu et al., 2023) 对文章进行摘要(必要时还包括翻译),以提炼文本的核心主张和主题 (see also Kojima et al., 2022; Liu et al., 2022; Wei et al., 2022; Zhou et al., 2023)。第二步,我们生成 “candidate pairs”,即一组更有可能提出相似主张的文档对。我们通过预训练的基于 BERT 的句子转换器模型来计算文档对之间的语义相似度分数 (Reimers and Gurevych, 2019),以此来识别这些候选对。这一环节与上文所述 human-in-the-loop 方法中的排序步骤类似。第三步,我们为 instruction-tuned LLM 设计了提示 (prompt),以识别哪些候选文档对在相同主题上包含相同主张,并将该提示应用于每一个候选对。进一步地,我们还展示了,当我们对 LLM 针对这一成对任务进行微调时,模型性能会显著提升。

数据

在本文中,我们利用自建的新闻网站语料库,估计在 2022 年 2 月俄罗斯对乌克兰发动全面入侵期间,美国媒体环境中的叙事相似性。我们的数据集由来自 45 个公共新闻网站的多语种新闻文章组成。其中包括4个俄罗斯官方媒体、18 个美国主流流行新闻网站、11 个美国低质量新闻网站,以及 12 个乌克兰新闻网站。之所以选择这样的新闻网站组合,是因为我们希望探究美国的哪些类型新闻网站可能在传播俄罗斯的叙事。我们将在后文的应用部分回到这一假设。

这 4 个俄罗斯来源是俄罗斯主要的国有媒体,面向国内和国际受众(包括塔斯社 TASS、《真理报》Pravda、今日俄罗斯 RT,以及卫星通讯社 Sputnik;see Henriksen et al., 2024)。18 个美国主流新闻网站均位列美国访问量前25的新闻网站之中。11个低质量网站来自 Allcott et al. (2019) 所识别的 569 个”假新闻”网站。最后,乌克兰媒体来源则是 Erlich et al.(forthcoming)所识别的高质量主流媒体。当条件允许时,我们收录了俄乌新闻网站的多语言版本:俄罗斯来源包括俄文与英文,乌克兰来源则包括俄文、乌克兰文与英文。

本研究的数据集共包含 692,560 篇新闻文章,发布时间范围为 2022 年 1 月 1 日至 2022 年 4 月 30 日,覆盖了 2022 年 2 月 22 日全面入侵前后各两个月的时间窗口。

出于多方面的考虑,我们将验证限制在这些文章的一个子集上,聚焦于一个具体案例:即关于”乌克兰正在操作由美国资助的生物武器”的谣言相关报道。尽管这种做法在推广性上存在局限,但我们仍选择如此。其主要原因与我们的召回验证任务有关,该任务要求我们通过人工编码来识别真实的正例。将研究聚焦于一个在整体语料中占比较大、同时内容网络相对封闭的文档集合,使我们能够在随机抽样中获得相对较高的正例匹配率,从而更有效地评估我们的方法。

方法

Concept-Guided Chain of Thought Summarization

我们首先对每篇文档进行摘要,提取其中的核心主张(claims)和主题(subjects),最后再执行无监督学习步骤。之所以这样做,出于理论上的考虑,我们预期这种方式能够提升模型表现。首先,计算机科学文献表明,将复杂的文档比较任务分解为更小的步骤,即采用”chain of thought” (Wei et al., 2022; Wu et al., 2023),可以提升性能。Chain of thought 指的是通过构造 LLM 的提示 (prompt),让模型生成完成复杂任务所需的中间推理步骤。快速增长的相关研究显示,生成式 LLM 在这种逐步、迭代的结构下表现显著更好,能够最大限度减少错误 (Kojima et al., 2022; Liu et al., 2022; Wei et al., 2022; Zhou et al., 2023)。Wu et al. (2023) 指出,研究者设计的一系列提示链可以进一步提升性能,尤其是在与数据标注相关的任务中。

这一发现的适用性远不止于 LLM,本质上也呼应了统计建模与机器学习中关于复杂性问题的长期理论贡献:在处理高维输入时,降维往往能够显著提高表现 (Hastie et al., 2009),而顺序化的降维方法通常能进一步改善性能。例如,在计算机视觉中,卷积神经网络通过在低维度到高维度逐步聚合信息来提升识别效果 (Gu et al., 2018)。

在我们的研究中,我们使用 instruction-tuned 的 LLM 对新闻文章进行摘要和核心提炼,采用两步法:

第一步,我们提示 GPT4o 将每篇文章总结为 7–10 句英文句子。这种将文章浓缩为标准化英文摘要的过程,在语言、格式、长度、风格以及主张数量等方面引入了一定的一致性,从而大幅降低了后续建模任务的有效维度 (effective dimensionality),并提高整体方法的表现。同时,这种语言标准化也是必要的,以避免在我们方法的第二步与第三步中出现不同语言之间的性能差异。提示词如下:

Summary: Please summarize this news article in 7–10 English sentences. Article: [insert article text]

第二步,我们向 GPT4o 提供两个独立的提示:一个要求提取摘要中出现的 “descriptive, normative, causal, and classificatory claims”(即”主张”),另一个要求提取 “people, places, things, and events”(即”主题”)。我们的提示要求 GPT4o 将这些主张和主题列出。这一”二次提炼”的步骤旨在抓取文章的关键信息。与其将完整文章或文章摘要输入下一阶段,我们选择让 LLM 比较这些提炼出的主张和主题列表。提示词如下:

Enumerate Subjects: Enumerate the people, places, objects, and events detailed in the following paragraph: [summary text]

Enumerate Claims: Enumerate the causal, normative, descriptive, and conceptual claims detailed in the following paragraph: [summary text]

我们之所以开发这一”主张—主题”分类体系,是基于在数据集中观察到的规律。由于我们的研究对象是新闻报道,其中最常见的论证形式是分类性主张(例如”Russia is a revisionist power”)、描述性主张(例如”Russia invaded Ukraine”)和因果性主张(例如”If Russia uses WMD, the U.S. will respond”),这是因为新闻生产者通常避免发表意见性判断,努力在新闻版块中呈现所谓”客观”的事实 (Schudson, 2001)。此外,我们也纳入了规范性主张 (normative claims),以防止数据库中混入了评论类文章。

Generating Candidate Pairs

比较主张与主题需要在所有相关文档之间执行成对操作,其计算复杂度为 O(n²)。为了减少需要在文章之间进行的比较次数,我们采用了一种计算成本较低的方法来生成”candidate pairs”,即在语义上相似、因此可能对相同主题提出相同主张的文章对。在这一步,我们的目标是尽可能多地过滤掉无关的文章对,同时保留所有实际存在叙事共性的案例。

我们利用 sentence transformers 或 SBERT (Reimers and Gurevych, 2019) 来识别更可能存在叙事重用的文章对,这一步应用于文章摘要(而非”主张与主题”列表)。SBERT 是对 BERT 语言模型的扩展,专门为成对语义相似性任务设计。SBERT 支持两种基本的句子(或段落)比较方式,我们在此均有所使用。第一种是 bi-encoder 方法:为每段文本分别生成嵌入向量,再利用余弦相似度等距离度量来判断相似文本。第二种是 cross-encoder 方法:将输入的文本对共同输入 BERT Transformer 网络中,直接生成一个相似度分数。虽然 cross-encoder 的计算成本高出数个数量级 (Lin, forthcoming; Reimers and Gurevych, 2019),但其结果通常更优。按照文献推荐,我们在候选生成步骤中结合使用了这两种方法。

具体而言,我们首先为数据集中每篇文章的摘要(而非”主张与主题”列表)生成嵌入,并计算所有嵌入向量之间的距离。在基于 recall 集调整的阈值下(下文讨论),我们将潜在的正例匹配数量从 609 万对减少到 392,320 对,通过 bi-encoder 步骤实现了超过 93% 的减少。在候选生成的第二步、也是最后一步中,我们将这 392,320 对文档输入 SBERT cross-encoder 模型。随后,我们根据该模型输出的语义相似度分数设定一个阈值,以决定哪些文档对应当纳入候选集合。这些阈值经过优化,能够尽可能剔除无关文档,同时保留 recall 训练集中尽可能多的正例。

最终,我们将候选文档对的数量从 392,320 对再次缩减至 64,677 对。在这一过程中,共丢弃了 6,027,118 对,占所有可能文档对 (6,091,795 对) 的 98.9%。

LLM Annotation

我们叙事相似性方法的最后一步是使用 LLM 对候选文档对的主张与主题列表进行直接比较和标注。在随后的部分,我们将把估计器的性能与 gold standard 的人工评估程序进行对比。为了尽可能与这一程序保持一致,我们设计了与人工编码员所使用的代码本一致的提示 (prompts)。对于每个候选对,我们的提示词为:

Same Subject: You will be provided with the lists of the people, places, objects, and events discussed in two paragraphs. Based on these lists, do the two paragraphs discuss the vast majority of the same people, places, objects, and events? Paragraph 1: [insert list] Paragraph 2: [insert list] Your label (Respond only with ‘YES’ or ‘NO’):

Same Claim: You will be provided with the lists of descriptive, normative, conceptual, and causal claims discussed in two paragraphs. Based on these lists, do the two paragraphs discuss the vast majority of the same claims? Paragraph 1: [insert list] Paragraph 2: [insert list] Your label (Respond only with ‘YES’ or ‘NO’):

在该步骤中,我们将来自 64,677 个候选文档对的相应列表(主张或主题)分别输入每一个提示一次。我们在此使用的模型为 GPT4o。我们将那些在 “same subject” 和 “same claim” 上均被标注为 “YES” 的文档对标记为预测的正例,即我们的估计器检测到存在叙事共性的文档对。我们将这一标注过程称为 zero-shot GPT4o annotator。

有效性验证

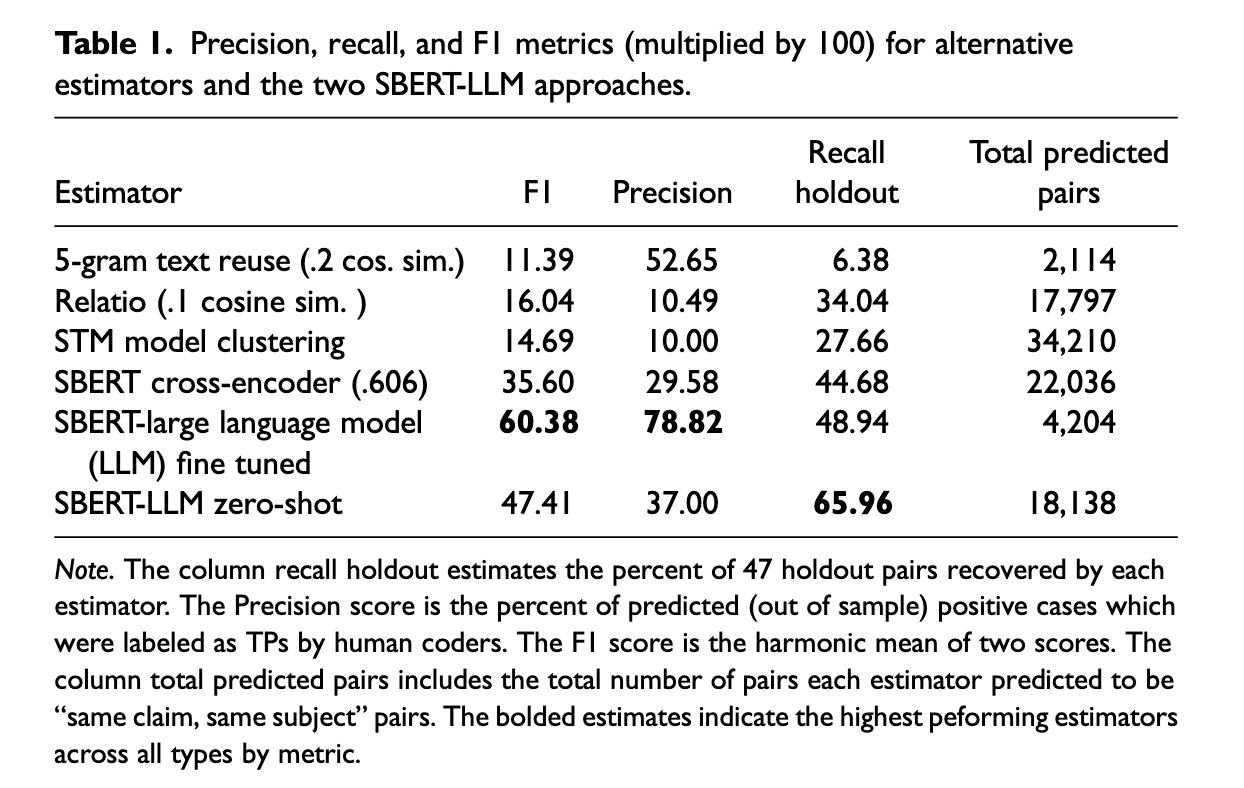

对这样一种无监督方法进行验证是困难的。以往描述无监督模型的研究通常并未将聚类标签与人工判断进行对照,而是呈现案例研究,或使用奖励簇内高特征相似性、簇间低特征相似性的指标。然而,这类指标往往与人工评估结果存在差异 (Grimmer and King, 2011)。不过,Grimmer and King (2011) 表明,对文档样本进行成对人工评估,可以生成近似于人工感知 gold standard 的有效性度量。然而,描述无监督方法的论文通常并未采用这种验证策略,尤其是在 recall 上,这可能是因为此类分析的成本过高。尤其是在正例比例很低的情况下,估计 recall 会变得极其昂贵。我们提出了一种验证策略,使我们能够在广为理解的监督学习指标下——即 recall、precision 和 F1——衡量我们的方法及上述替代的无监督方法的表现。特别是,我们提供了一种衡量 recall 的策略,该策略受到过去研究中利用人工编码员辅助机器分类的启发 (Lu et al., 2024)。具体而言,我们首先使用成对相似度度量对候选正例进行排序,然后让人工对其进行编码,直至触发一个停止规则。我们通过让人工标注员对各方法识别为正例的文档对进行标注来衡量 precision。我们发现,我们的方法在 out-of-sample 表现上有所提升,尽管在 precision 与 recall之间存在一定的权衡。

Results

- Recall:

- 传统的 exact text reuse方法在 recall 上几乎完全失效(仅召回 6.4%),即使在宽松阈值下也无法有效捕捉叙事共性。

- 出乎意料的是,LLM-based 估计器(zero-shot 与 fine-tuned)在 recall 上均显著优于 topic modeling,显示仅依赖词汇相似度不足以识别叙事重合。

- SBERT 的 候选生成步骤极大降低了计算成本(剔除 98.9% 的无关 pairs),却几乎未损失 recall。

- Precision:

- exact text reuse方法 precision 高(53%),但 recall 极低。

- topic modeling与 relatio precision 最差(约 10%)。

- SBERT-LLM的 precision 在 fine-tuning 后大幅提升:由 37% → 78.8%,说明微调显著增强了模型区分”相似但非同一叙事”的能力。

- F1(综合指标):

- SBERT-LLM 流水线在 F1 上远超其他方法,即使不微调也优于所有 baseline;

- fine-tuned SBERT-LLM表现最佳,是唯一在 recall 与 precision 之间取得较好平衡的估计器。

应用

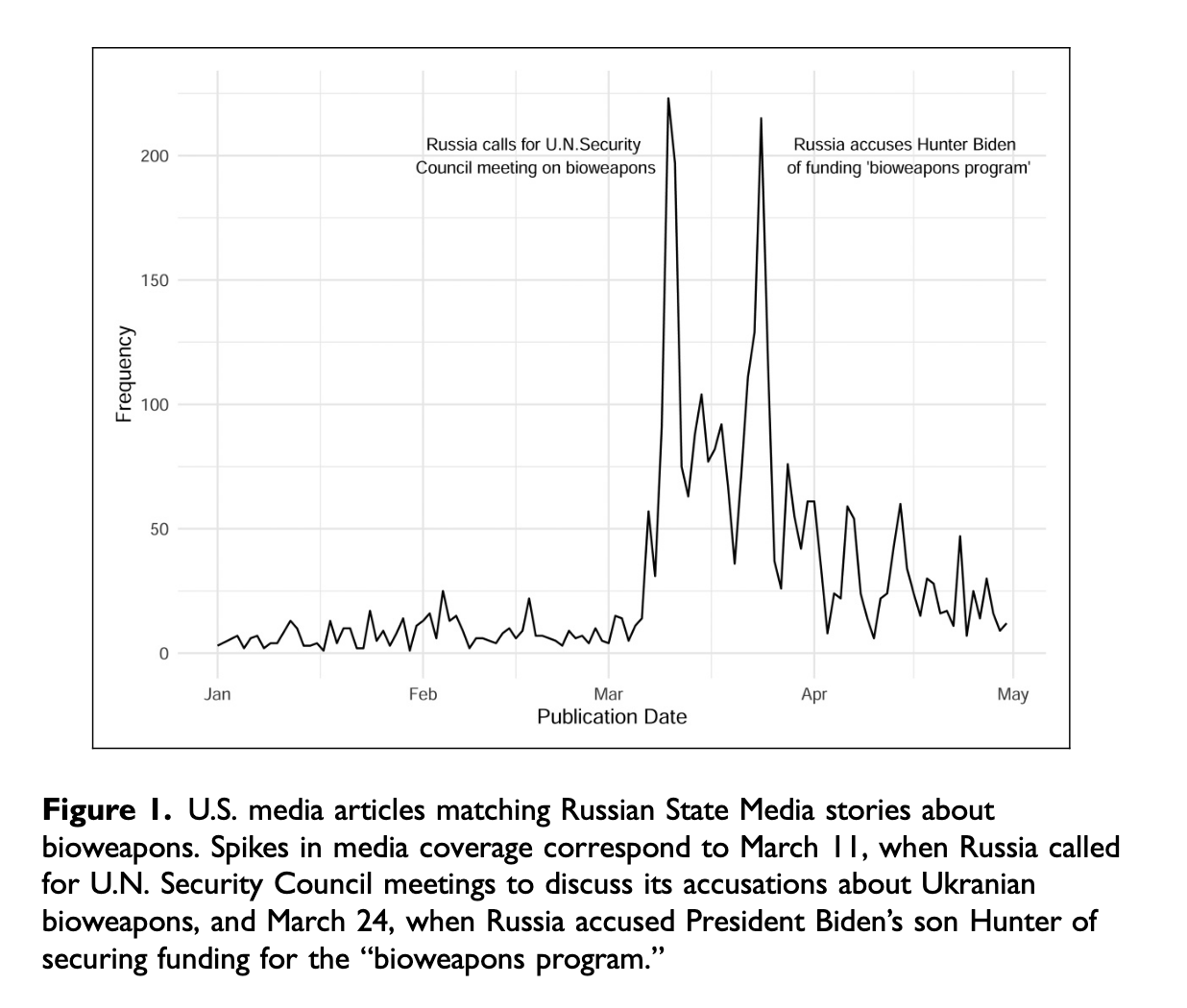

图 1 展示了美国媒体报道与俄罗斯国家媒体生物武器叙事重合的文章数量随时间的变化趋势,大多数文章发表于三月,并持续到了四月。

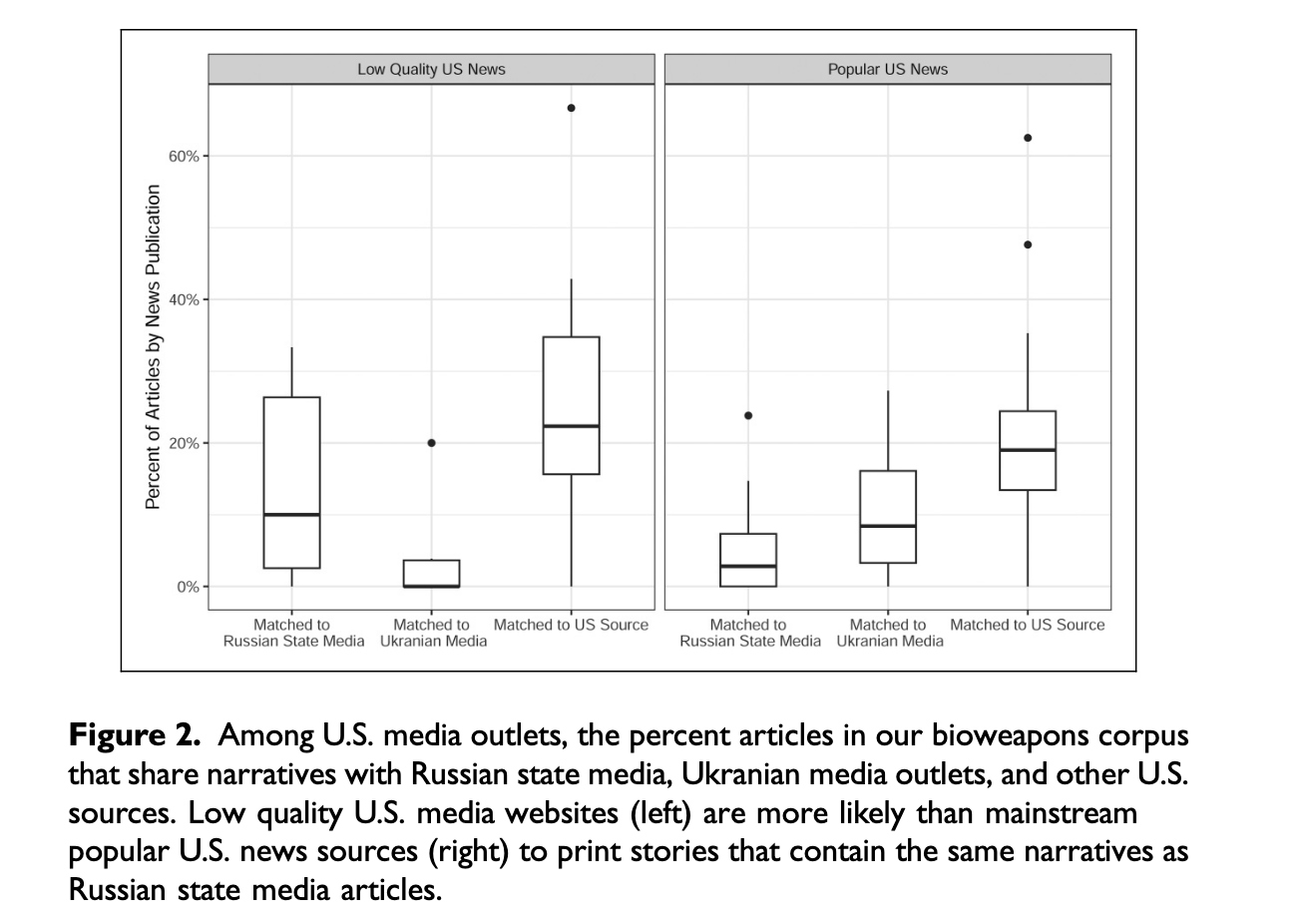

图 2 比较了低质量美国新闻网站(左)与 主流美国新闻网站(右)在生物武器相关报道中,与不同信息源(俄罗斯媒体、乌克兰媒体、其他美国媒体)的叙事重合比例。发现:低质量网站更容易重复俄罗斯国家媒体的叙事(14.1% vs. 5.4%);低质量网站同样更容易与其他美国媒体叙事重合,但与主流媒体的差距较小;趋势相反,主流媒体比低质量网站更容易与乌克兰媒体叙事重合。

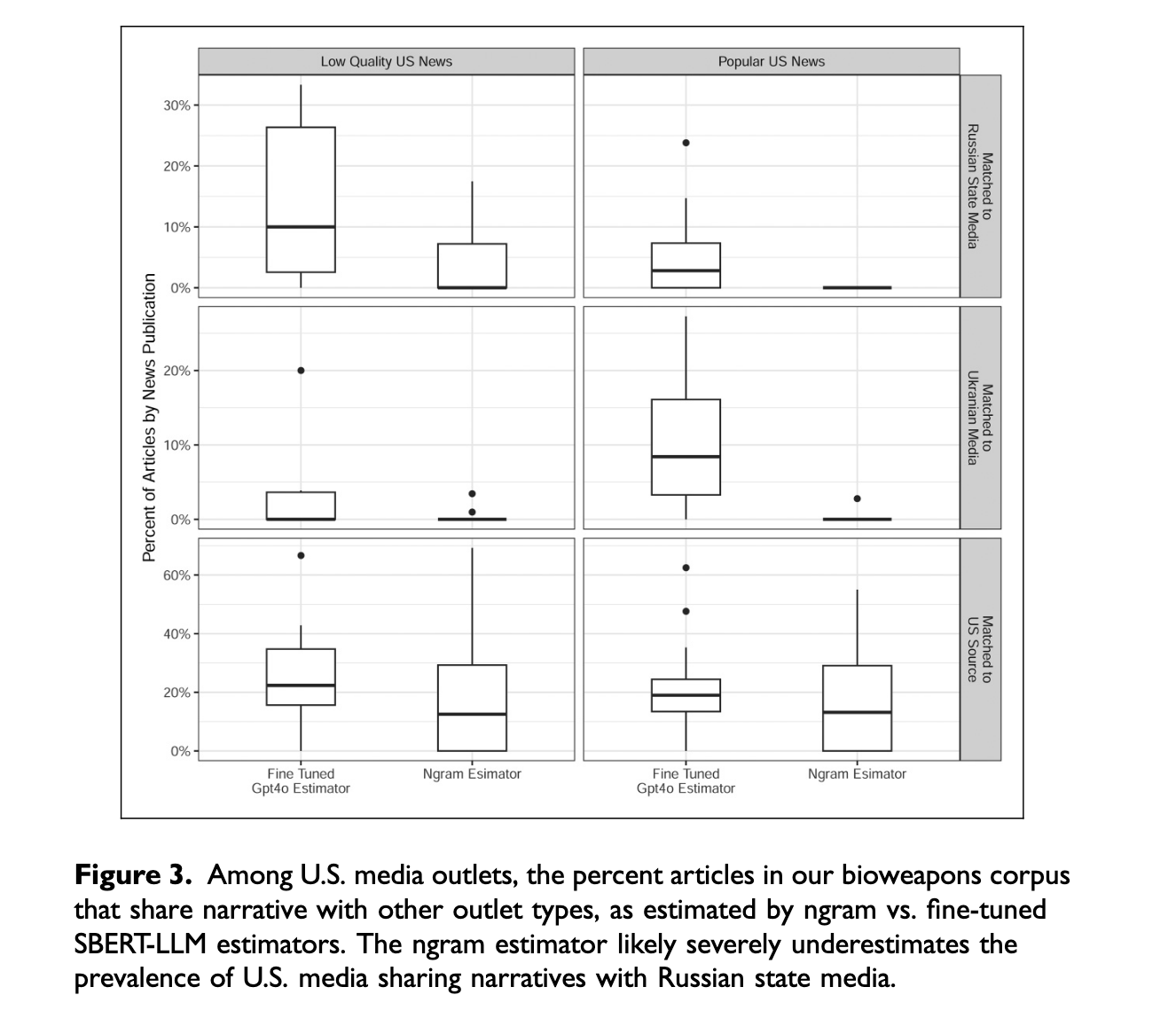

图 3 比较了 ngram estimator 与 fine-tuned SBERT-LLM estimator 在估计叙事重合时的差异。在 美国媒体之间 的叙事重合(底部面板):两种方法结果接近,说明美国媒体内部的叙事重合大多依赖逐字复制。在与 俄罗斯媒体(顶部面板)和 乌克兰媒体(中间面板)的叙事重合上:两种方法差异显著。特别是,ngram 方法没有识别出任何主流美国新闻网站与俄罗斯国家媒体的直接文本重合,而 SBERT-LLM 却发现平均近 10% 的叙事重合。所以:基于 exact text reuse 的低召回率方法(如 ngram)不仅会低估叙事重合的真实规模,还可能完全遗漏某些现象(例如主流美国媒体与俄罗斯媒体的叙事重合)。相比之下,SBERT-LLM 方法能够更全面揭示跨媒体叙事扩散的真实情况。

原文信息

文献来源: Waight, H., Messing, S., Shirikov, A., Roberts, M. E., et al. (2025). Quantifying Narrative Similarity Across Languages. Sociological Methods & Research.

原文链接: 请点击左下方【阅读原文】